Les militaires peaufinent des soldats électroniques capables de décider de tuer. Enquête.

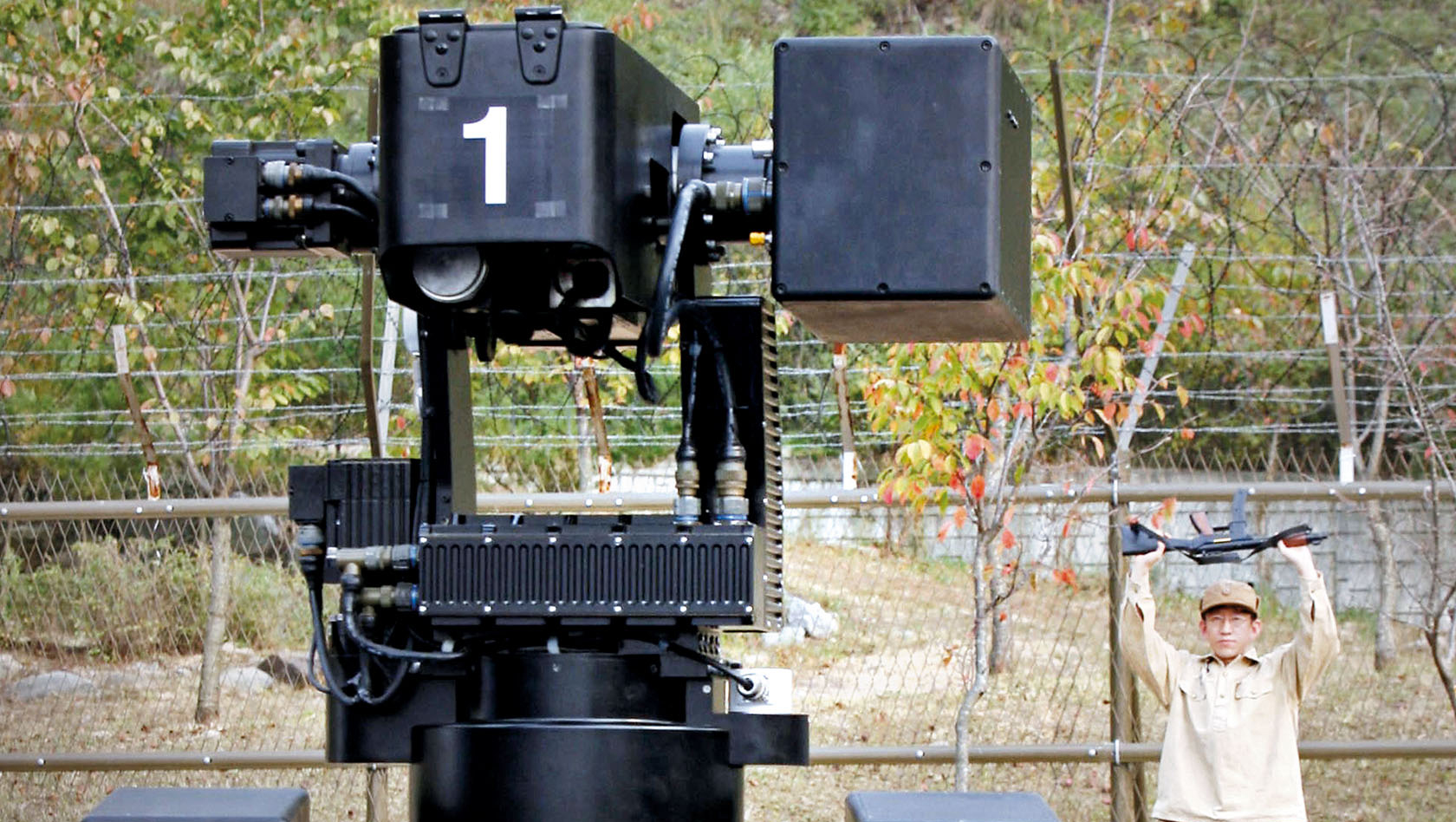

E n 2010, la Corée du Sud a confié la surveillance de la zone démilitarisée qui suit sa frontière avec sa voisine du Nord, à un robot conçu par le groupe Samsung : SGR-A1. Équipé de caméras et de capteurs, il peut détecter des cibles dans un rayon de quatre kilomètres.

Cette sentinelle trapue – elle mesure 1,20 m et pèse 117 kg – est aussi lourdement armée, d’une mitrailleuse et d’un lance-grenades. Et surtout, son système de reconnaissance vocale lui permet, le cas échéant, si elle repère des intrus qui ne possèdent pas les bons mots de passe et ne s’arrêtent pas à ses tirs de semonce, de les abattre – après avoir tout de même requis le feu vert d’un opérateur humain.

En somme, l’« infatigable » (dixit Samsung) SGR-A1 est un robot tueur, d’autant plus inquiétant qu’il peut très facilement devenir complètement autonome et se passer de toute autorisation pour guerroyer. L’activation de son mode « automatique » lui permet en effet d’ouvrir le feu de sa propre et seule initiative.

Il en existe quelques autres, comme le dispositif de défense anti missile qui équipe les navires de guerre de la marine américaine depuis 1980. Phalanx – parfois surnommé R2D2 en raison de sa ressemblance avec le fameux robot de la saga Star Wars – peut « acquérir » seul une cible, puis la « neutraliser ».

De même, le « bouclier » israélien Dôme de fer, en service depuis 2010, est capable de détecter et de détruire automatiquement les roquettes lancées vers Israël depuis le Liban et la bande de Gaza.

Et désormais, ce sont toutes les armées, que les industriels de la défense alléchés par un marché d’avenir, ambitionnent d’automatiser et d’autonomiser, sur terre, en mer, et dans les airs.

Au prétexte, récurrent, que le déploiement sur les champs de bataille de robots chargés d’effectuer les missions les plus risquées permettrait de réduire significativement le nombre des combattants humains directement exposés au danger.

Vaines alarmes

Un robot pointe ses armes vers un intrus dans le camp d’entraînement de Cheonan, près de Séoul, en Corée du Sud. 28 septembre 2016. © AFP PHOTO / Kim Dong-Joo

Insensibles à ce bel enthousiasme – où le sort des civils qui se trouveraient pris dans des guerres robotisées compte, il est vrai, pour très peu –, plusieurs dizaines d’organisations non gouvernementales (ONG), dont Amnesty et Human Rights Watch, réclament depuis 2013 l’interdiction des robots tueurs.

Pour les initiateurs de cette campagne, « abandonner à des machines un droit de vie ou de mort » revient à « franchir une ligne morale fondamentale ».

Car, expliquent-ils, « le jugement humain et la compréhension des contextes permettent seuls de faire des choix complexes sur un champ de bataille, pour distinguer les soldats des civils, et pour estimer la proportionnalité d’une attaque : tout cela disparaîtrait avec l’emploi de robots autonomes, qui contreviendrait par conséquent aux lois de la guerre ».

Or, ces engins ne savent pas reconnaître seuls un civil d’un combattant. SGR-A1, par exemple, considère a priori tout intrus comme un ennemi : on imagine sans peine à quelles effroyables tueries ils pourraient se livrer, s’ils étaient abandonnés à une complète autonomie.

D’autre part, « remplacer des troupes conventionnelles par des machines faciliterait le déclenchement des guerres ». Les États s’engageraient d’autant plus volontiers dans ces conflits qu’ils auraient l’assurance de pouvoir se prévaloir, auprès de leurs opinions publiques, d’opérations « zéro mort ». Cela, conjugué avec l’absence de définition claire d’une chaîne de responsabilités dans l’emploi d’armes autonomes, renforcerait le sentiment d’impunité et « se traduirait par toujours plus de souffrances pour des populations civiles .

En 2014, les Nations unies, interpellées par ces ONG, lancent enfin une série de discussions – toujours en cours au moment où ces lignes sont écrites – autour des « systèmes d’armement létaux autonomes » (Sala).

À lire aussi : Les Nations unies à l’heure des «robots tueurs»

La crainte du marché noir

20 lauréats du prix Nobel de la paix appellent à leur tour à l’interdiction immédiate des robots tueurs.

Au même moment, vingt lauréats du prix Nobel de la paix appellent à leur tour à l’interdiction immédiate des robots tueurs. Ils sont rejoints, l’année suivante, par plusieurs milliers de scientifiques – spécialistes, pour la plupart, de l’intelligence artificielle –, qui publient, en juillet 2015, une lettre ouverte réclamant l’interdiction des Sala.

Les signataires réfutent l’argument, systématiquement privilégié par les suppôts de la guerre robotisée, selon lequel « remplacer des hommes par des machines permet de limiter le nombre de victimes du côté de celui qui les possède ». Ils prédisent plutôt que les robots tueurs, apparaîtront rapidement « sur le marché noir ».

Leur confection ne nécessitant aucun matériel de base coûteux ou difficile à obtenir – contrairement à celle des armes nucléaires – ces robots finiront inévitablement par tomber entre les mains « de terroristes, de dictateurs désireux de contrôler davantage leur population et de seigneurs de guerre souhaitant perpétrer un nettoyage ethnique ».

En 2015 toujours, Amnesty International observe que le sujet suscite désormais « beaucoup de débats, mais peu d’actes ». L’ONG demande à nouveau « une interdiction au niveau mondial des robots tueurs létaux » qui « ne seraient pas conformes aux normes internationales relatives aux droits humains » et « ne respecteraient pas les lois de la guerre ».

Au mois d’août 2017, constatant que ces multiples alarmes restent vaines, le milliardaire américain Elon Musk, fondateur du spécialiste des bolides électriques Tesla, cosigne, avec une centaine d’autres patrons d’entreprises dédiées à la robotique et à l’intelligence artificielle, une nouvelle lettre ouverte alarmiste aux Nations unies.

Il est urgent d’ « agir », écrivent-ils, car « une fois que la boîte de Pandore » sera ouverte, il sera « très difficile de la refermer ».

Course aux armements

De fait, en quelques années, de nombreux pays, et non des moindres, comme les États-Unis, la Chine, le Royaume-Uni et la Russie, sourds aux alertes de la société civile, se sont lancés dans ce qu’il faut bien appeler une course aux armements robotisés.

Au mois de juin 2016, pendant que le débat s’éternise à l’ONU, des experts du Pentagone rédigent un long et très inquiétant rapport. Ils exhortent le gouvernement américain, où cette objurgation ne rencontre que peu de résistance, à « accélérer sa conversion aux armes autonomes », à renforcer « les équipes opérationnelles » et bien sûr les budgets nécessaires à cette mutation.

Les auteurs de cette glaçante étude militent donc pour « la délégation » de toujours plus de prises de décisions « à des entités » – des machines – qui seront dès lors « autorisées à prendre seules des initiatives, dans certaines limites ». Afin que nul doute ne subsiste, ils soulignent que : « Les systèmes gouvernés par des prescriptions qui n’autorisent aucune initiative sont des systèmes automatisés, mais ne sont pas autonomes ».

Pour être véritablement « autonome, un système doit être capable, pour atteindre ses objectifs, de faire son propre choix, basé sur sa connaissance et sa compréhension du monde lui-même et des situations, parmi différentes options ».

Selon ces fervents partisans de la robotisation des armées, il est désormais possible, grâce aux extraordinaires « progrès » réalisés dans le domaine de l’intelligence artificielle, de « déléguer » à de tels systèmes « des tâches qui ont longtemps été regardées comme irréalisables par des machines ». Et c’est, de leur point de vue, une excellente nouvelle. Car en sus de formidables opportunités commerciales, cela, expliquent-ils, permettra de réduire significativement « le nombre des combattants » humains « exposés au danger ».

Un futur cauchemardesque

Un soldat guidant un robot SL3 au fort Devens Mass. Beedle-USA

Au même moment, en France, où prévaut, comme souvent lorsqu’il est question d’armement, une forme assez aboutie d’hypocrisie gouvernementale, le groupe français Safran présente à Paris, au Salon international de la défense et de la sécurité Eurosatory 2016, son robot tactique eRider, destiné aux forces terrestres.

Selon ses concepteurs, ce « drone », est capable de « comprendre son environnement et de s’y mouvoir efficacement et en toute sécurité ». Son aspect général ne diffère que peu de celui d’un banal véhicule tout-terrain et il peut être piloté comme n’importe quel 4×4.

Doté par un acheteur de quelques « équipements complémentaires issus » du « catalogue de produits » du groupe, comme par exemple un « viseur d’observation de conduite de tir », il pourra « mener ses missions en autonomie partielle ou totale ». Dans la presse française, ce salon soulève de vifs enthousiasmes.

Chacun mesure là, au contact des marchands d’armes, que « la digitalisation envahit le champ de bataille ». Une journaliste du quotidien économique Les Échos s’extasie : « Dans un monde où les préoccupations de sécurité reviennent en tête des priorités nationales et où les bouleversements technologiques s’accélèrent au point de valider certains scénarios de science-fiction, tout est là pour transformer le combattant en un “soldat augmenté” à l’œuvre sur un champ de bataille robotisé. (…) L’imagination est au pouvoir, du mini-drone que le soldat tiendrait par un fil comme un enfant un ballon pour observer le champ de bataille au drone anti-émeute, capable d’arroser les manifestants de gaz lacrymogènes ».

Vidéo : Military robot navigates through woods

Que demander de plus ?

Plusieurs pays travaillent sur des “essaims de robots”

L’envoyée spéciale du Figaro n’est pas moins enthousiaste : « Comme l’industrie, les armées ont engagé leur révolution numérique. Robots terrestres et sous-marins, drones, big data, intelligence artificielle s’engagent dans leurs rangs ».

Et cela, récite-t-elle, leur permettra de « gagner en efficacité tout en exposant le moins possible la vie humaine » à ce que les Anglo-saxons appellent les « 3D: ce qui est sale (dirty), pénible (dull) et dangereux (dangerous) ».

Elle poursuit, ravie : « Plusieurs pays travaillent sur des “essaims de robots” ». Son enquête montre qu’en France, les premières études ont été lancées en 2012 par la Direction générale de l’armement (DGA).

Deux ans plus tard, les premiers tests sont menés en extérieur. Et de citer l’ingénieur de l’armement en chef, responsable de la prospective robotique à la DGA : « Un scénario a été défini, impliquant un essaim de 12 robots aériens et terrestres dirigés par un unique opérateur ».

Ces premiers tests « concluants », l’objectif est désormais de disposer d’unités robotiques opérationnelles d’ici à 2030. La collaboratrice du Figaro oublie, comme sa consœur des Échos, de mentionner que cette perspective – où sont en jeu, précise-t-elle, des « milliards de dollars » – est regardée comme cauchemardesque par de nombreux observateurs.

Surtout, elle néglige de préciser, pour son lectorat, que le groupe Dassault, propriétaire de son journal, est directement intéressé par la poursuite d’un tel programme. Au printemps 2016, en effet, la France et le Royaume-Uni ont décidé d’allouer deux milliards d’euros à la confection du « Système de combat aérien du futur » (Scaf) : un drone de guerre furtif qui devrait être opérationnel en 2030.

« Un robot tueur, doté d’une intelligence artificielle qui lui permettra de prendre la décision d’ouvrir le feu après évaluation du contexte », estime Tony Fortin, de l’Observatoire des armements, . Et c’est le groupe Dassault qui a été chargé, conjointement avec l’entreprise britannique BAE Systems, de le mettre au point…

— Dossier réalisé par Sébastien Fontenelle, avec Aymeric Elluin pour La Chronique d’Amnesty International