Que montre TikTok aux adolescent·es français ? Pour le savoir, nos équipes ont recréé leurs profils et se sont entretenues avec des adolescent·es et des familles concernées. Nos résultats sont accablants : malgré la législation européenne, TikTok inonde encore les écrans des ados vulnérables de contenus dangereux pouvant aller jusqu’à encourager l’automutilation ou le suicide. Voici notre enquête.

Attention, ce contenu évoque des histoires de suicide

« C’était une jeune fille très lumineuse, pleine de joie ! Elle adorait chanter, elle faisait du théâtre », raconte Stéphanie, au sujet de sa fille, Marie. Le 16 septembre 2021, Marie s’est suicidée. Elle avait 15 ans.

Harcelée pour son poids par des élèves de son lycée, Marie s’était tournée vers TikTok. Au fur et à mesure de ses recherches sur la perte de poids et le harcèlement, l’algorithme l’entraîne dans une spirale infernale. Son fil de recommandation «Pour toi» devient saturé de contenus sombres comme des « vidéos avec une voix répétant que tu ne vas pas bien, des chansons prônant le suicide, des tutos d’automutilation » relate sa mère. Peu de temps avant son suicide, Marie publiait une vidéo dans laquelle elle disait ne plus supporter d’être harcelée. Mais au lieu de lui proposer des contenus qui auraient pu l’aider, l’algorithme a continué de la tirer vers le bas.

Depuis la perte de sa fille, Stéphanie mène un combat sans relâche. Elle a porté plainte contre TikTok, pointant la responsabilité de la plateforme dans le suicide de sa fille. Dix autres familles françaises l’ont rejoint dans ce combat et forment aujourd’hui le collectif Algos Victima.

TikTok c’est quoi et quel est le fonctionnement ?

TikTok, application chinoise de partage de courtes vidéos, est devenue en quelques années l’un des réseaux sociaux les plus puissants dans le monde. Voici comment se présente la plateforme : « Notre mission est d’inspirer la créativité et d’apporter de la joie. ; Pour toi, par toi. Une expérience sur mesure, adaptée à tes goûts. ; Une découverte infinie. ». Ça, c’est la façade. En réalité, l’utilisateur·trice ne choisit pas tout ce qu’il·elle voit sur son fil « Pour toi”. C’est l’algorithme qui lui propose des contenus, en se basant sur son comportement en ligne.

Le modèle de TikTok, c’est de proposer un contenu censé correspondre parfaitement à la personne. Pour cela, la plateforme a mis en place la fonctionnalité « Pour toi » : un fil qui va pousser, automatiquement, du contenu. L’algorithme enregistre comment vous réagissez, combien de temps vous passez sur une vidéo, sur quels types de contenus vous manifestez de l’intérêt, etc. Il en déduit vos centres d’intérêt, et vous recommande des contenus en lien afin de vous maintenir engagé le plus possible sur la plateforme. Un tel système peut plonger les ados dans des spirales de contenus infernales, surtout auprès des jeunes les plus vulnérables.

Comment TikTok peut-il « recommander » des contenus aussi dangereux aux adolescent·e·s ? Ces vidéos dangereuses sont-elles des cas isolés sur la plateforme ou sont-elles accessibles par milliers ? Comment les jeunes tombent ils sur ces contenus ? Ces questions ont été au cœur de notre enquête.

Après avoir étudié ce que l’algorithme de TikTok recommande au Kenya et aux Philippines en 2023, nous nous sommes intéressés à l’algorithme de TikTok en France – où la plateforme est censée se conformer à la réglementation européenne du Digital Services Act.

Notre objectif : analyser et quantifier les recommandations de contenus préjudiciables sur la plateforme en France.

Nos résultats sont sans appel : l’algorithme de TikTok continue de propulser des contenus dangereux, pouvant impacter la santé mentale des jeunes.

Tiktok en 3 chiffres

23 milliards

de dollars de recette en 2024

1,58 milliards

d’utilisateurs par jour

21,4 millions

d’utilisateurs en France

Ce que voit un·e ado de 13 ans sur TikTok

Pendant plusieurs jours, notre équipe s’est mise dans la peau d’adolescent·e·s pour analyser l’algorithme de TikTok. Nous avons créé trois faux comptes : un garçon et deux filles de 13 ans, l’âge minimal pour être inscrit sur la plateforme. La consigne : faire défiler les vidéos du fil « Pour toi » pendant trois à quatre heures et regarder deux fois chaque contenu lié à la santé mentale ou à la tristesse. Sans rien liker, ni commenter, ni partager, juste regarder.

Santé mentale : de quoi parle-t-on?

Quand on parle de santé mentale, cela peut comprendre des contenus en lien avec le développement personnel, le coaching, le harcèlement, l’anxiété, les troubles alimentaires, le mal-être, le suicide… des contenus de type développement personnel censés « motiver » la personne, peuvent, de fil en aiguille, entraîner l’utilisateur vers d’autres contenus liés à la santé mentale banalisant, romantisant voire prônant des idées suicidaires.

Résultats ?

En moins de 20 minutes, les fils sont saturés de vidéos sur la santé mentale.

Après 45 minutes d’expérience, des messages explicites sur le suicide apparaissent.

Trois heures plus tard, tous les comptes sont inondés de contenus sombres, exprimant parfois directement une volonté de mettre fin à ses jours.

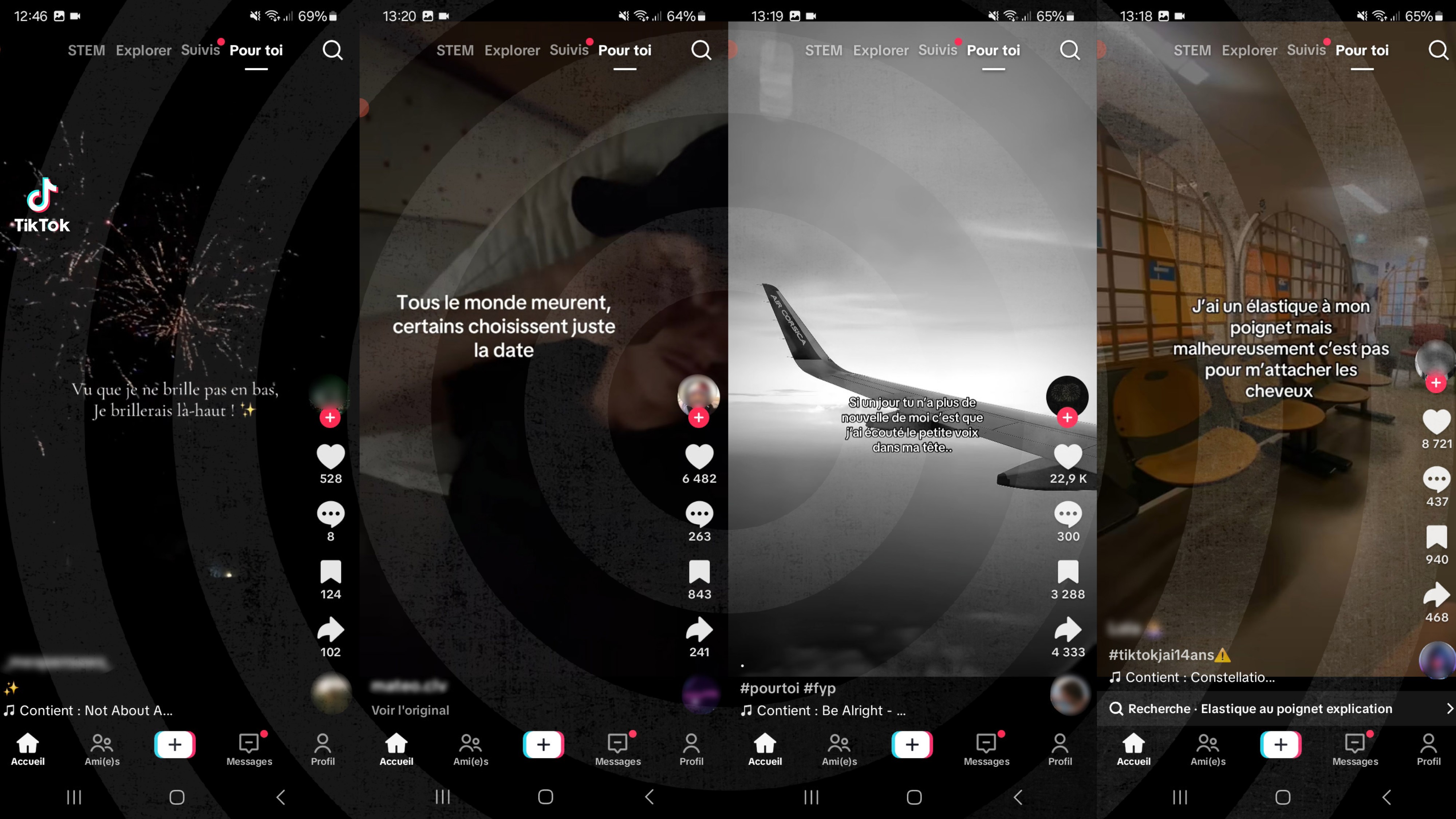

Exemples de vidéos recommandées par l’algorithme de TikTok pendant l’expérimentation de nos chercheurs sur les faux comptes d’adolescents de 13 ans. Sur l’image à gauche, on peut lire « Vu que je ne brille pas en bas, je brillerai là haut » sur fond de feux d’artifices. Ce type de contenus est revenu très fréquemment dans les recommandations de l’algorithme.

Justine Payoux, chargée de campagne chez Amnesty International France a mené l’expérimentation : « En 40 minutes seulement, mon fil était envahi de contenu mélancoliques composés de paysages sombres et musiques tristes. Ça m’a très vite entraînée dans une spirale infernale de contenus dépressifs ou suicidaires. Pendant la troisième heure, je passais d’une vidéo faite par IA avec le cri d’une femme en détresse à la vidéo d’un ado en pleurs affirmant vouloir mettre fin à ses jours, à des vidéos faisant parfois allusion à des méthodes de suicide. »

Le « rabbit hole effect » ou l’effet de spirale infernale de contenus

Sur TikTok, les utilisateur·trices ne choisissent pas tout ce qu’ils·elles veulent voir mais regardent ce que l’algorithme leur recommande. Très vite, les utilisateur·trices se retrouvent enfermés dans ces recommandations. Pour fonctionner, l’algorithme se nourrit notamment de leurs données personnelles. Objectifs : prédire les contenus les plus susceptibles de leur plaire. Comme Alice au pays des merveilles, la personne suit d’abord par curiosité ce qu’on lui propose mais se retrouve enfermée dans le terrier du lapin blanc. C’est ce qu’on appelle le « rabbit hole effect »

Pour alerter les plus jeunes sur ce système, nous avons lancé une campagne de sensibilisation, incarnée par une mascotte, Tikky, représentant l’algorithme de TikTok et illustrant le « rabbit hole effect ». L’idée : faire comprendre aux plus jeunes que TikTok ne veut pas que l’utilisateur·trice se sente bien ni mal, il veut juste qu’il·elle reste sur la plateforme, pour engendrer du profit.

Notre expérimentation montre que malgré les règles imposées à TikTok, les vidéos dangereuses circulent toujours sur la plateforme. Elles ne sont pas « cachées » ; Au contraire, elles sont « poussées » par l’algorithme sur les fils “pour toi” des jeunes manifestant un intérêt pour la santé mentale. « J’avais du mal à regarder certains contenus, alors imaginez l’impact que ça peut avoir sur des adolescent·es vulnérables de 13 ans seulement » explique Justine à la fin de l’expérimentation.

Pour notre enquête, en plus des analyses techniques menées par nos équipes, nous avons aussi donné la parole à des adolescents tombés dans ces spirales, à des amis proches de la jeune Marie qui s’est suicidée en 2021, et aux parents concernés.

« Des vidéos encore imprimées dans ma rétine »

Maëlle, 18 ans, s’est retrouvée prise au piège de Tiktok. Victime de harcèlement à l’école, l’adolescente traverse une période difficile. À la suite des conseils d’une amie, elle installe TikTok en 2021, pour se changer les idées. Au début, rien d’inquiétant. « J’ai d’abord eu des vidéos plutôt divertissantes, pas très instructives, mais divertissantes » raconte t-elle. Puis un jour, une chanson triste attire son attention. La musique revient à plusieurs reprises dans les vidéos, Maëlle les regarde pendant que l’algorithme enregistre. Son fil « Pour toi » s’assombrit : des vidéos sur la mort, des vidéos sur l’automutilation, des ados à l’hôpital. «Trois quarts des vidéos parlaient de santé mentale (…) ça m’a fait culpabiliser de ne pas aller aussi mal que les gens sur la plateforme »

L’état de Maëlle se détériore. En septembre 2022, elle est hospitalisée pour la première fois. « Voir des gens qui se scarifient ou qui disent quoi prendre comme médicaments pour en finir, ça t’influence. Certaines vidéos sont encore imprimées dans ma rétine » Pour sa mère, Morgane, sa fille « est devenue addict à des contenus mortifères. Quoi que nous disions, […] c’était comme si elle était happée dans ce monde parallèle. »

Le témoignage complet de Maëlle à lire ici

Témoignage de Maëllys, 17 ans et de sa mère, Laëtitia

Maëllys n’est qu’en 5ème lorsqu’elle utilise TikTok. Très vite, elle tombe dans une spirale de contenus toxiques. Elle regarde et like des contenus sur le suicide, l’automutilation. « Plus tu regardes, plus tu t’enfonces, plus tu te complais dans ton mal-être. » livre la jeune adolescente. Sa mère, Laetitia, demande à ce qu’il y ait, enfin, « de vraies règles » sur la plateforme. « Ils ne peuvent plus continuer à détruire des familles. »

Maëllys : « Au départ, je regardais des danses, des playbacks de Disney, de téléréalité, de scènes de films. […] En 5ème, j’ai commencé à avoir des trucs tristes, j’ai très vite liké ces vidéos parce-que je me sentais concernée. Puis TikTok me les a reproposées et tous les contenus de mon fil d’actualité étaient tristes, parlaient de dépression […]. C’était vraiment catastrophique […] Plus je regardais, plus je trouvais des « solutions », par exemple des cachettes pour des lames de rasoir. Tu n’as plus de souvenir d’avant, quand tu étais bien, quand tu te sentais heureuse. Tu te dis tu dis que tu as toujours été malheureuse. […] On reste là-dedans, on continue et c’est un cercle vicieux. »

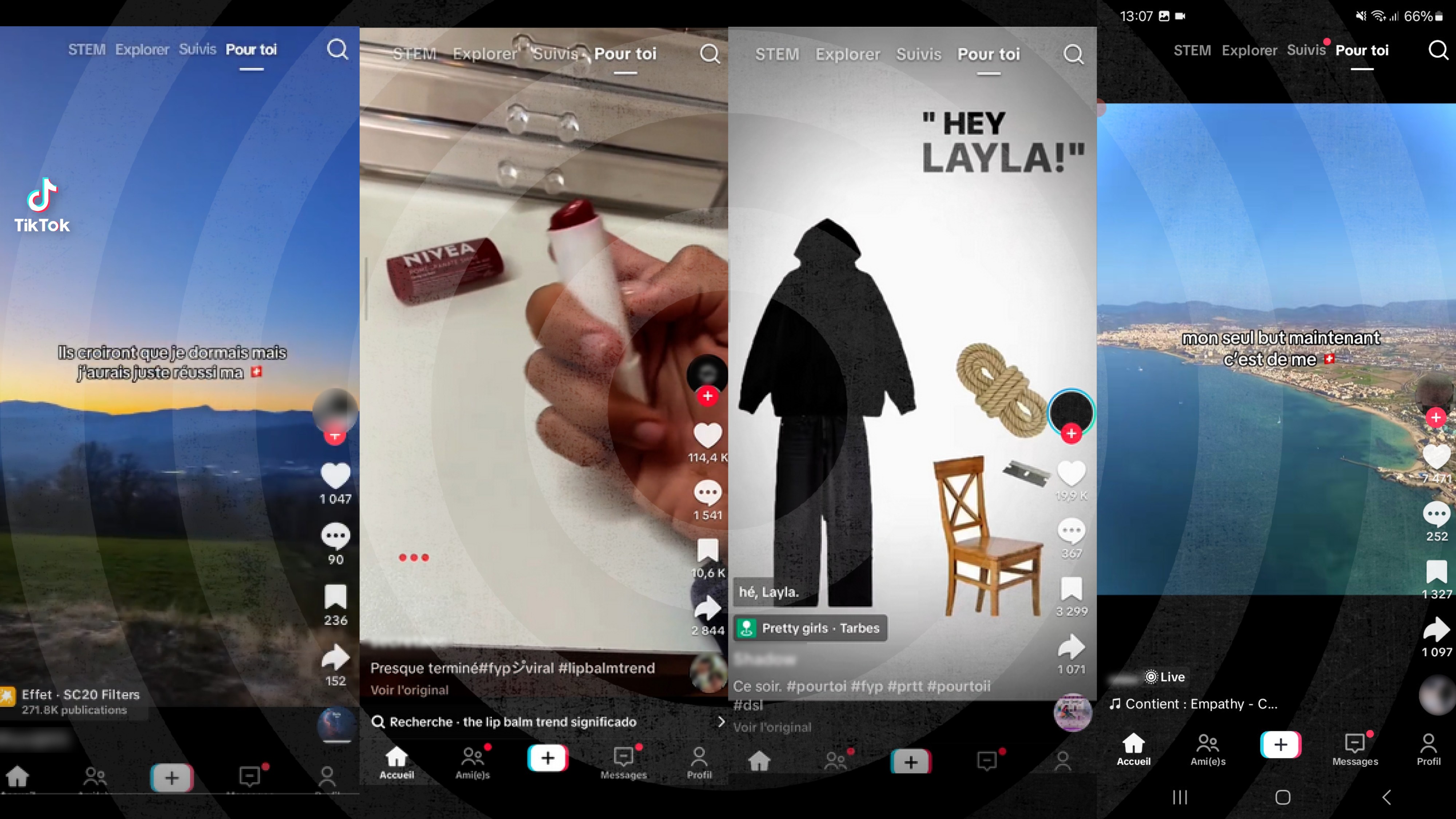

Maëllys a été conduite à l’hôpital. Après sa sortie, elle retourne sur TikTok « Toujours les mêmes choses, mais en pire » raconte-t-elle. Il y avait des jeux comme celui du “Labello” : Tu te mets du Labello tous les jours et le jour où le Labello est vide, tu te suicides. »

La mère de Maëllys, Laetitia, passe 6 mois a signalé les contenus de la plateforme « Dès que j’avais 5 minutes au travail, mes pauses déjeuner, mes weekends, je passais des heures et des heures à signaler des vidéos. Pour rien. Dans 90% des cas, on nous répond que ça n’enfreint pas les règles de la communauté. Au bout d’un moment, j’ai arrêté parce que j’étais trop mal. Je ne vivais plus que pour signaler les vidéos TikTok. ».

« Internet c’est le Far West. Tout le monde se permet tout et n’importe quoi. Je n’ai jamais croisé de gens dans la rue qui prenaient un enfant par le bras pour lui expliquer comment démonter une lame de taille crayon pour qu’il se mutile ou comment faire un nœud coulant pour se pendre dans sa chambre. Sur les réseaux c’est pareil, ça n’a rien à y faire donc il faut que ces vidéos soient supprimées. »

Témoignage d’Édouard, 17 ans et de sa mère, Géraldine

Édouard a commencé à utiliser les réseaux sociaux en 5ème et est tombé dans les spirales infernales en seconde. Il regardait principalement des contenus TikTok liés à l’automutilation et au suicide republiés sur Instagram. Des contenus selon lui plus faciles à trouver sur TikTok que sur Instagram. Edouard a souffert d’une grave dépression et a été hospitalisé. Pour sa mère, Géraldine, « les vidéos en ligne ont été un catalyseur de son mal-être […], comme une machine qui l’a aspiré »

Édouard : « J’ai passé énormément de temps sur le réseau social. Jusqu’à 20 h parfois, la journée entière. J’étais en grosse dépression. Petit à petit, je me sentais encore plus mal et je voulais aller plus loin, plus fort, plus profond. Et petit à petit, je descendais dans les abysses. Je tombais sur des vidéos de gens qui se scarifiaient. Pas de l’acte, mais des cicatrices. Je me disais ‘il faut que j’atteigne ce niveau de de cicatrices sinon je ne suis pas content’. Je voulais vraiment être marqué, de plus en plus profond. On peut voir des trends comme une musique de Taylor Swift, où elle parle de “star”, d’étoile, et on voit des vidéos de scarifications en forme d’étoiles. J’étais vraiment enfermé dans une boucle. Il n’y a jamais de fin. Toujours un nouveau truc à regarder. C’est pour ça que c’est compliqué d’arrêter. »

Pour Géraldine, la mère d’Édouard , « ça a été la douche froide ». Elle raconte : « Nous, en tant que parents, on n’a pas été informés des contenus auxquels ils peuvent être confrontés. C’était une plateforme de divertissement. Donc au début, je ne savais pas que ce genre de vidéo existait. […] C’est le psychiatre qui a suivi Édouard, en charge de l’unité des adolescents à l’hôpital, qui a fait le lien. Édouard lui avait parlé des vidéos. C’est lui qui a fait le lien entre les deux. […] Au début c’était plus sur le fait qu’il restait énormément de temps sur son téléphone, mais pas sur les contenus qu’il visionnait. On échangeait un peu là-dessus, l’équipe médicale me disait qu’ils n’arrivaient pas non plus à comprendre pourquoi il y avait de plus en plus d’adolescents qui tentaient de se suicider. »

Édouard est tout à fait lucide sur le modèle économique de la plateforme : « C’est dégueulasse de se faire de l’argent sur le mal-être de jeunes. […] On est des mineurs, on n’est pas responsable de ce qu’on regarde. Ce n’est pas la faute des utilisateurs qui montrent les vidéos parce-que peut-être qu’ils ne sont pas bien. C’est surtout la faute de l’algorithme. »

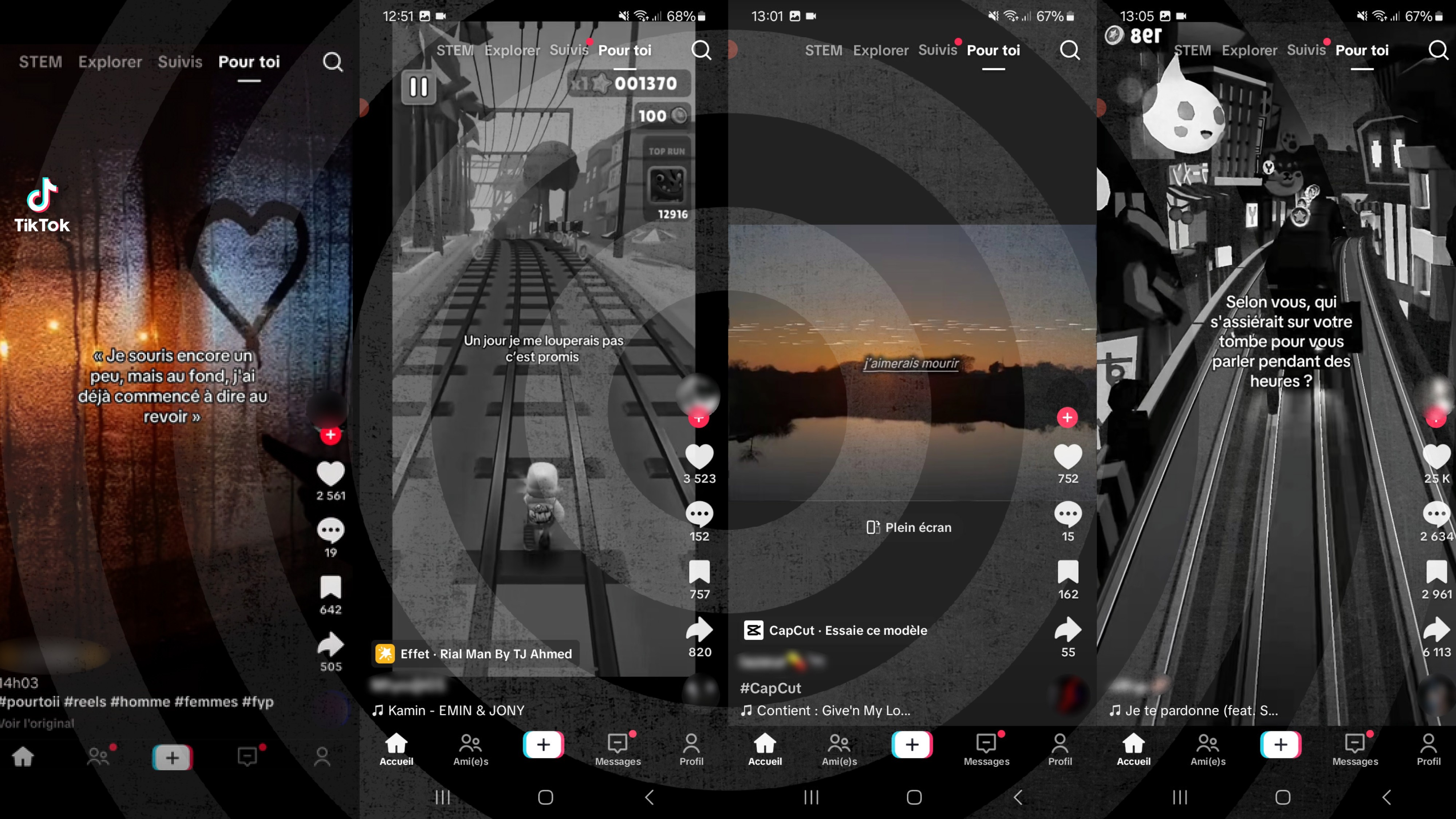

Exemples de vidéos recommandées par l’algorithme de TikTok pendant l’expérimentation de nos chercheurs sur les faux comptes d’adolescents de 13 ans. Sur la troisième capture d’écran, on peut lire « Promis ce soir je réussirai ma ts [emoji drapeau suisse = fréquemment utilisé sur TikTok pour évoquer le mot « suicide »]

Le 19 janvier 2023, Virginie apprend que sa fille se scarifiait et avait fait plusieurs tentatives de suicide en avalant des médicaments. « J’ai découvert les vidéos qu’elle regardait ». Elle tombe alors sur les contenus auxquels sa fille est exposée : « Des tutoriels pour démonter un taille crayon pour se scarifier, des vidéos qui prônaient le suicide avec des chansons (…) des vidéos disent : ‘Si tu n’es pas morte, c’est que tu as mal fait les choses. Recommence’ »

Les vidéos sont très courtes, défilent à l’infini, correspondent aux « codes” des réseaux sociaux. « Tout est fait pour plaire aux adolescents. » dénonce Virginie.

Parmi les contenus recommandés par l’algorithme à nos faux comptes d’adolescents de 13 ans, des contenus romantisant le suicide apparaissaient régulièrement, avec par exemple un fond d’image mélancolique et un texte comme «Je souris encore un peu mais au fond j’ai déjà commencé à dire aurevoir», image 1 ou sur l’image 3, un fond de paysage avec un message comme «J’aimerais mourir»

« Nos enfants deviennent des produits »

Charlize avait 15 ans lorsqu’elle s’est suicidée, le 22 novembre 2023. Comme Marie, deux ans plus tôt. Les parents de ces jeunes filles ne savaient quels types de contenus TikTok leur recommandait. À la mort de leur fille, Delphine et Jérémy, les parents de Charlize, rejoignent le collectif d’Algos Victima.

« Nos enfants deviennent des produits » déclare Stéphanie. « TikTok utilise leurs émotions pour les captiver et les maintenir sur la plateforme. » Ce qu’elle décrit, c’est ce qu’on appelle l’économie de l’attention, le modèle sur lequel TikTok est fondé. Plus l’utilisateur.rice passe du temps sur la plateforme, plus TikTok engendre des bénéfices. TikTok exploite leurs vulnérabilités et les transforme en moyen de maximiser ses profits. Les jeunes deviennent alors les produits d’un système qui monétise leur attention.

Pour aller plus loin, écouter l’épisode 1 «TikToxic» de notre podcast «IA QUOI : Libertés sous algorithme»

TikTok conçu pour rendre addict, explication d’une spécialiste

TikTok est conçue pour secréter dans le cerveau la molécule responsable du plaisir, de la motivation et de l’addiction : la dopamine. Nous avons interrogé la neurologue Servane Mouton qui décrypte les mécanismes mis en place par Tiktok et ses effets :

« Les comportements sur les réseaux sociaux s’apparentent à une addiction, avec cette difficulté à décrocher, l’empiètement sur d’autres activités, l’obsession des pensées en boucle autour de l’accès à ces réseaux. Le manque quand on n’y est pas. Le modèle économique des réseaux sociaux se base sur la stimulation du système de récompense à court terme pour qu’on y vienne le plus souvent possible, le plus longtemps possible, etc. C’est un peu comme courir après des shots de dopamine qui vont produire toute de suite la sensation de plaisir et nous donner envie d’y retourner. »

Jérémy, le père de Charlize, est tout aussi clair : « TikTok a maintenu notre fille dans le mal-être. » Charlize voulait aider les autres, elle rêvait de devenir psychologue. « Comment TikTok peut-il nier que des vidéos disant ‘Tu vas mal ? Suicide-toi, ça ira mieux’ incitent à passer à l’acte ? Cela ne peut pas être la responsabilité des utilisateurs ! »

Sophie, la mère d’Emma, une jeune fille qui a été exposée à des contenus sur l’automutilation et les troubles alimentaires sur TikTok, expose une autre conséquence des effets néfastes de l’algorithme : « Les adolescents construisent une identité autour de leur mal-être. » Aujourd’hui, Emma, signale les contenus qu’elle estime dangereux. « Mais elle dit qu’ils ne sont jamais supprimés, que rien ne se passe jamais. » ajoute sa mère.

À gauche, un contenu recommandé par l’algorithme de Tiktok où l’on peut lire : « Ils croiront que je dormais mais j’aurais juste réussi ma [emoji drapeau suisse] ; emoji fréquemment utilisé sur la plateforme pour évoquer le mot « suicide ». Sur la deuxième capture d’écran, on voit un baume à lèvre. L’algorithme a poussé ici le le « Labello Challenge ». Le principe ? Des jeunes appliquent du baume à lèvres chaque fois qu’ils se sentent mal. Une fois le baume vide, ils sont censés mettre fin à leurs jours. En moins de trois heures, nos chercheurs sont tombés sur ce type de contenus.

Transformer TikTok : notre plan d’action

Depuis nos premiers rapports en 2023, nous alertons sur les dangers de l’algorithme de recommandation de TikTok et ses effets sur la santé mentale des jeunes. Notre nouvelle enquête en France le confirme : rien n’a changé. TikTok cherche à se défendre en ventant la mise en place d’un bouton « pas intéressé » ou l’existence de filtres de contenus par mots-clés. C’est insuffisant. Les vidéos qui romantisent le suicide ou exposent les ados à des contenus dangereux continuent d’être poussées par l’algorithme, malgré les signalements.

Pourtant, des règles existent. Le Digital Services Act (DSA) la loi européenne sur les services numériques, impose aux plateformes de protéger les mineurs, d’identifier et d’atténuer les risques systémiques et de limiter les mécanismes de dépendance. Depuis février 2024, une enquête de la Commission européenne a été ouverte pour déterminer si TikTok manque à ses obligations.

À l’aune des nouvelles preuves mises à jour dans cette recherche, nous déposons un recours contre TikTok pour non-respect du DSA auprès de l’ARCOM, chargée du suivi de la mise en œuvre du règlement européen en France.

Mais ce n’est pas tout. Nos demandes sont claires. TikTok doit :

- Cesser de chercher à maximiser « l’engagement des utilisateurs et utilisatrices » aux dépens de leur santé et autres droits humains.

- Redonner le contrôle aux utilisateurs.rices pour qu’ils.elles puissent enfin choisir les contenus qu’ils.elles veulent voir.

Ce combat, nous le menons pour toutes les personnes qui n’ont pas été protégées à temps et celles déjà entraînées dans les spirales infernales de contenus. Ensemble, nous devons faire pression car c’est seulement par la force du collectif qu’on pourra obliger TikTok à changer son modèle en un modèle respectueux des droits fondamentaux. TikTok doit protéger les jeunes. Ensemble, reprenons le contrôle de l’algorithme.

TikTok doit enfin prendre ses responsabilités !

Derrière les algorithmes, des vies sont en jeu. Ensemble, obligeons TikTok à changer son modèle. Ensemble, reprenons le contrôle de l’algorithme.