Pour toute demande d'interview ou pour recevoir nos communiqués de presse, contactez-nous* :

PAR EMAIL

PAR Téléphone

+33 6 76 94 37 05 (soir et weekend compris)

*Contact réservé exclusivement aux journalistes. Pour toute autre demande, contactez le standard au 01 53 38 65 65 ou notre Service Relations Membres et Donateurs à [email protected].

Communiqués de presse

Retrouvez tous les communiqués publiés par Amnesty International.

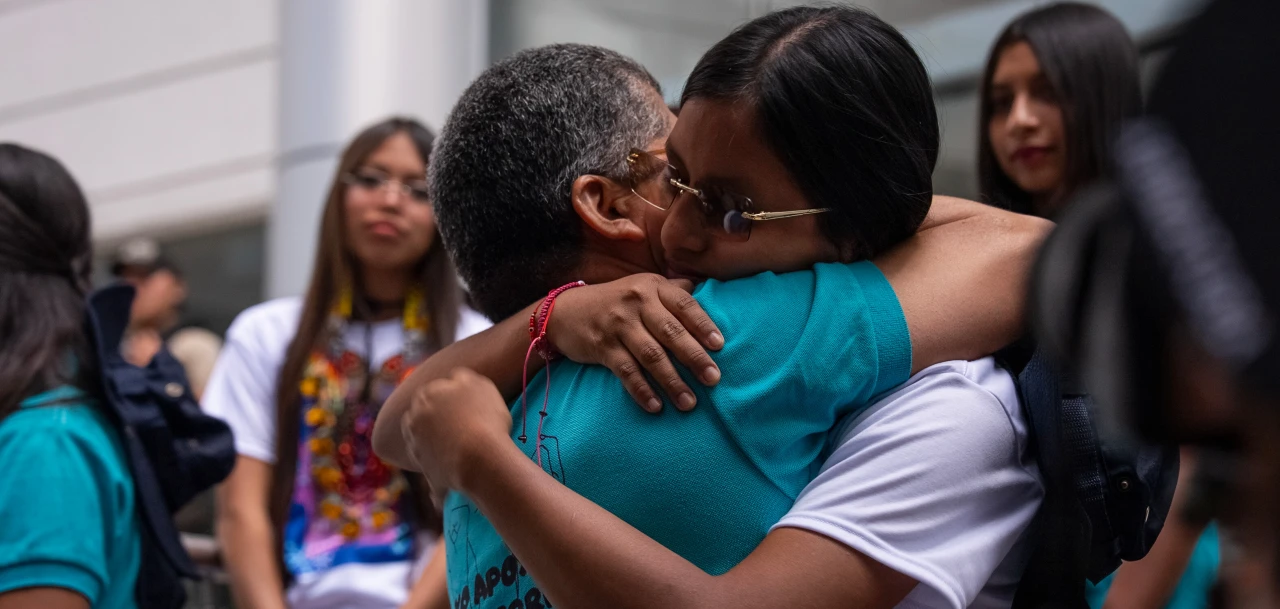

©Benjamin Girette /

Agenda

Retrouvez le planning presse prévisionnel du mois à venir (rapports, communiqués, évènements…).

© Yannis BEHRAKIS / REUTERS / Des migrants et des réfugiés supplient des policiers macédoniens de les laisser franchir la frontière près du village grec d’Idomeni, le 10 septembre 2015.

nos derniers rapports

Retrouvez tous les rapports publiés par Amnesty International.